Începând cu iOS 15 ce se va lansa luna viitoare, Apple a confirmat faptul că noua opțiune CSAM (Child Sexual Abuse Material) va putea scana pozele din iCloud pentru a identifica abuzurile cu minori.

Au fost multe discuții pro și contra privind această nouă opțiune, iar Apple a decis să iasă în față și să explice exact ce face CSAM și cum poate ajuta autoritățile pentru a preveni abuzurile la care sunt supuși minorii.

Acest sistem va fi activat în prima fază doar în SUA urmând apoi ca fiecare țară să aleagă dacă îl vrea sau nu. Pentru Europa lucrurile sunt un pic mai diferite datorită GDPR însă Apple a confirmat că nici un fel de date nu sunt colectate privind identitatea utilizatorilor.

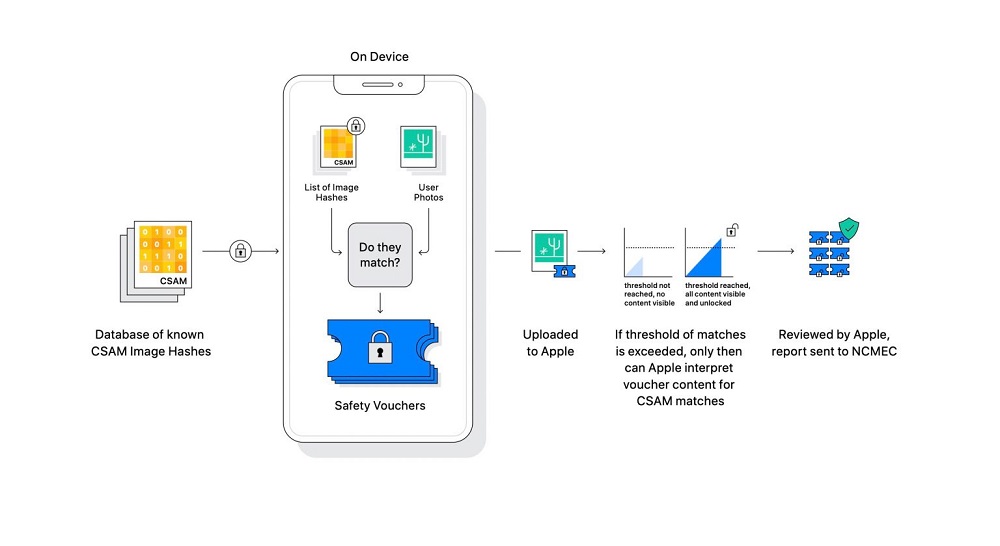

Sistemul CSAM ar folosi niște hashes cu ajutorul cărora să poată identifica pozele cu minori în pielea goală, abuzați sau în ipostaze indecente alături de adulți. Totul se întâmplă pe fiecare dispozitiv în parte și nu are legătură cu serverele Apple.

Se ia în discuție și varianta deschiderii acestui sistem CSAM pentru integrarea lui cu diverse aplicații din App Store, însă acest lucru cel mai probabil va fi disponibil după ce acest sistem va fi testat o anumită perioadă de timp.

Acest sistem va funcționa doar pentru pozele stocate în iCloud, iar cum majoritatea utilizatorilor nu cumpără spațiu extra de 200GB/2TB pentru a își stoca pozele, ci le salvează pe laptop/desktop/SSD extern nu văd cum ar putea funcționa corect acest serviciu CSAM. Rămâne să vedem.

Până atunci, voi ce părere aveți despre acest sistem?

Urmărește-mă pe Google News sau activează

0 Comentarii