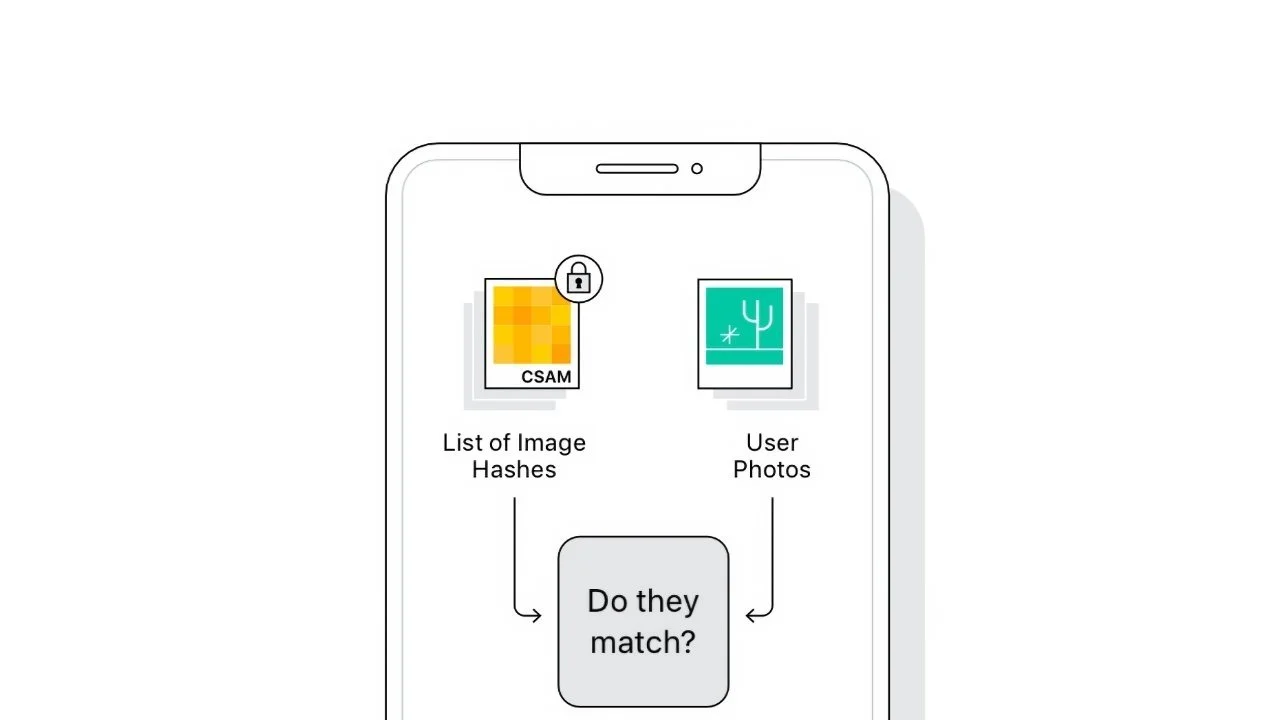

Luna trecută, Apple a anunțat că va introduce un nou tool numit CSAM cu ajutorul căruia să poată scana pozele din iCloud pentru a detecta poze cu minori abuzați.

Iată ce spune Apple într-o declarație trimisă către cei de la 9to5mac după ce în spațiul public au apărut diverse solicitări să nu activeze o astfel de funcție chiar dacă ea ar ajuta la abuzurile privind minorii. Între timp s-a aflat că Apple a folosit acest sistem CSAM scanând deja mailurile stocate în iCloud încă din 2019.

Last month we announced plans for features intended to help protect children from predators who use communication tools to recruit and exploit them, and limit the spread of Child Sexual Abuse Material. Based on feedback from customers, advocacy groups, researchers and others, we have decided to take additional time over the coming months to collect input and make improvements before releasing these critically important child safety features.

–Apple

Sunt convins că vor urma niște procese legate de acest sistem CSAM, mai ales în Europa dacă vor alege să îl activeze începând cu iOS 15. Se pare că Apple a făcut un pas înapoi și va amâna lansarea acestuia.

Urmărește-mă pe Google News sau activează

0 Comentarii